- пошукова оптимізація

- контекстна реклама

- email-маркетинг

- вірусний маркетинг

- досвід роботи більше 10 років

- робота з ТОП-вими агенствами

- Україна, Росія, Казахстан

- більше 100 кейсів у різних тематиках

- ріст продажів інтернет-магазину

- збільшення середнього чека

- зменшення вартості залучення

- повний контроль над бюджетом

- щомісячна звітність про роботу

- постійний зв'язок з клієнтом

- брендинг

- Email – маркетинг

- вірусний маркетинг

- пошукове просування

- соціальні мережі

- досвід роботи більше 10 років

- просування топових клієнтів України, Росії та Казахстану

- просування порталів i.factor.ua meta.ua

- зниження вартості відвідувача

- робота з ВЧ ключами

- аналіз юзабіліті

- контрольований бюджет

- щомісячний звіт

- постійний зв'язок з клієнтом

- контекстна реклама

- соціальні мережі

- Email – маркетинг

- вірусний маркетинг

- пошукова оптимізація

- досвід роботи більше 10 років

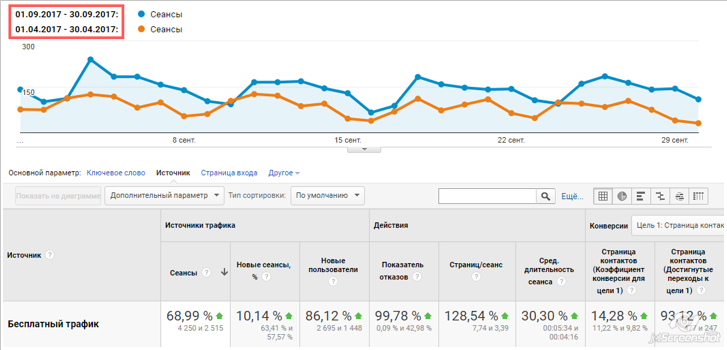

- коефіцієнт конверсії до 30%

- підвищення окупності

- покращення конвертації трафіку

- опрацювання усіх сегментів аудиторії

- щомісячний звіт

- контрольований бюджет

- старт з мінімальним бюджетом (100$)

- пошукове просування

- контекстна реклама

- соціальні мережі

- Email – маркетинг

- вірусний маркетинг

- досвід роботи більше 10 років

- успішне просування pixus.ua та arttex.com.ua

- аналіз інтересу аудиторії

- залучення лідів

- зниження вартості відвідувача

- контроль бюджету

- постійний зв'язок з клієнтом

Нам довірили свій бізнес більше 500 клієнтів

Заявка відправлена!

Ви вже вирішили стати нашим клієнтом чи у Вас ще є питання? Заповніть короткий бриф на розкрутку сайту або ознайомтеся з нашими послугами у презентації.

Сайт повинен приносити прибуток!

Інтернет - джерело нових клієнтів. Саме вони дозволяють рости існуючим комерційним проектам і розвиватися новим. Замовлення будь-яких digital-послуг в студії Fresh IT - це частина інвестиційного процесу. Сайт повинен бути активом, а інвестиції в трафік повинні приносити очікуваний прибуток.

Заповніть анкету - і ми абсолютно безкоштовно дамо вам пораду, як змусити ці ресурси працювати на вас.

або 99% вашого успіху

Білі методи просування

Індивідуальний підхід

Досвід та професіоналізм

Економія бюджету

Прозорість звітності

Сертифіковані партнери Google

Ми навчимо ваш сайт заробляти гроші

ОТРИМАТИ КОНСУЛЬТАЦІЮЕфективне просування сайту, розкрутка сайтів

Ви втомилися від спеціалістів, які увесь час закуповують посилання та накручують поведінкові фактори? Набридло, що ваш сайт не приносить дохід? Хочете працювати на результат і з гарантією?

Це можливо! Все, що необхідно зробити, — замовити розкрутку сайту або налаштування контекстної реклами у професіоналів. Ефективне просування сайтів потребує серйозного підходу та широкого досвіду. В компанії Fresh IT працюють сертифіковані спеціалісти, на рахунку кожного з котрих сотні успішно реалізованих стратегій пошукового просування. Ефективна розкрутка сайту - це приваблення нових клієнтів та утримання вже відвідавших сайт клієнта.

Перше, що ми чуємо від клієнта, - це питання «скільки коштує просування сайту і коли буде результат?».

Фактори, які впливають на вартість розкрутки сайту:

- тематика ресурсу;

- масштаб сайту;

- цілі компанії;

- активність конкурентів

- сезонність тематики;

- регіональність сайту(Київ, Дніпро, Харків, Одеса, Запоріжжя та інше).

Орієнтовно середній термін просування сайту в пошукових системах - 6 місяців з моменту запуску стратегії.